»[…] wenn ›die Quelle‹ die Reliquie historischen Arbeitens ist – nicht nur Überbleibsel, sondern auch Objekt wissenschaftlicher Verehrung –, dann wäre analog ›das Archiv‹ die Kirche der Geschichtswissenschaft, in der die heiligen Handlungen des Suchens, Findens, Entdeckens und Erforschens vollzogen werden.«1 Achim Landwehr wirft in seinem geschichtstheoretischen Essay den Historikern ihren »Quellenglauben« vor – diese Kritik ließe sich im digitalen Zeitalter leicht auf die Heilsversprechen der Apostel der »Big Data Revolution« übertragen.2 Zwar regen sich mittlerweile vermehrt Stimmen, die den »Wahnwitz« der digitalen Utopie in Frage stellen,3 doch wird der öffentliche Diskurs weiterhin von jener Revolutionsrhetorik dominiert,4 die standardmäßig als Begleitmusik neuer Technologien ertönt.5 Statt in der intellektuell wenig fruchtbaren Dichotomie von Gegnern und Befürwortern, »First Movers« und Ignoranten zu verharren, welche die Landschaft der »Digital Humanities« ein wenig überspitzt auch heute noch kennzeichnet, ist das Ziel dieses Beitrages eine praxeologische Reflexion, die den Einfluss von digitalen Infrastrukturen, digitalen Werkzeugen und digitalen »Quellen« auf die Praxis historischen Arbeitens zeigen möchte. Ausgehend von der These, dass ebenjene digitalen Infrastrukturen, Werkzeuge und »Quellen« heute einen zentralen Einfluss darauf haben, wie wir Geschichte denken, erforschen und erzählen, plädiert der Beitrag für ein »Update« der klassischen Hermeneutik in der Geschichtswissenschaft. Die kritische Reflexion über die konstitutive Rolle des Digitalen in der Konstruktion und Vermittlung historischen Wissens ist nicht nur eine Frage epistemologischer Dringlichkeit,6 sondern zentraler Bestandteil der Selbstverständigung eines Faches, dessen Anspruch als Wissenschaft sich auf die Methoden der Quellenkritik gründet.

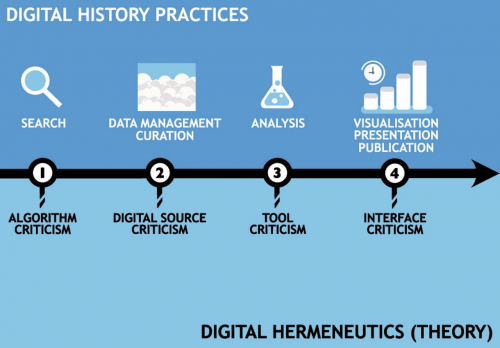

Schon 2006 stellten Daniel Cohen und Roy Rosenzweig fest, dass alle Historiker, auch wenn sie sich selbst nicht als »digitale« Forscher verstünden, in ihrer Arbeitspraxis längst zu solchen geworden seien.7 Im letzten Jahrzehnt hat sich dieser Trend weiter verstärkt: Die massenhafte Retrodigitalisierung analoger Quellenbestände hat uns vom »Age of Scarcity« ins »Age of Abundance« (Cohen/Rosenzweig) katapultiert. Kein Historiker kann heute die phänomenale Transformation negieren, welche die Flut an retrodigitalisierten wie digital entstandenen »Quellen« für die Geschichtswissenschaft bedeutet.8 Wir haben es aber nicht nur mit einem quantitativen Phänomen zu tun, sondern die Arbeit mit Digitalisaten oder »Metaquellen« stellt Historiker vor epistemologische Herausforderungen, die im Zuge einer digitalen Hermeneutik für die Geschichtswissenschaft reflektiert werden müssen.9 Die digitale Quellenkritik – oder besser: geschichtswissenschaftliche Datenkritik – nimmt einen zentralen Stellenwert in dieser digitalen Hermeneutik ein. Letztere geht aber darüber hinaus, indem sie den gesamten Arbeits- bzw. Forschungsprozess einbezieht, der sich von der Fragestellung über die Informationssuche, Analyse, Interpretation bis zur Repräsentation und Darstellung neuen historischen Wissens erstreckt.10 In allen Phasen des geschichtswissenschaftlichen Arbeitens greifen digitale Infrastrukturen und Werkzeuge wie Online-Bibliotheks- oder Archivkataloge, Web-basierte Datensätze und Suchalgorithmen sowie Soft- und Hardware zur Datenbearbeitung und Repräsentation aktiv in den Denk- und Handlungsprozess historischer Sinnbildung ein.

(Grafik: Ghislain Sillaume,

Luxembourg Centre for Contemporary and Digital History, 2019)

Trotz der Omnipräsenz des Digitalen zeichnet sich die historische Praxis aber durch Hybridität aus: »Klassische« oder »traditionelle« Formen der Recherche (offline) – etwa in analogen Archiv- und Bibliotheksbeständen – gehen Hand in Hand mit Online-Recherchen; die Annotation von Texten oder Bildquellen mit Bleistift oder Kugelschreiber gehört ebenso zum Repertoire wie die Kommentierung oder das »Taggen« digitaler Datenbestände. »Hybridity is the new normal« – so brachte es der niederländische Historiker Gerben Zaagsma auf den Punkt.11 Gerade diese Hybridität stellt aber eine methodologische und epistemologische Doppelbelastung für die aktuelle Geschichtswissenschaft dar, weil neben erlernten und etablierten wissenschaftlichen Methoden und Standards auch der Umgang mit neuen Techniken, Begriffen und Konzepten kritisch angeeignet werden muss. Sich in dieser Übergangsphase oder »Trading Zone« zwischen unterschiedlichen »Communities of Practice« und epistemologischen Traditionen (etwa zwischen Geistes- und Computerwissenschaften oder Data Sciences) zu bewegen erfordert ein erhöhtes Maß an Selbstreflexivität sowie die Bereitschaft, sich in kritisch-hermeneutischer Tradition mit der Realität geschichtswissenschaftlicher Praxis im digitalen Zeitalter auseinanderzusetzen.12 In der Spannung zwischen dem Vertrauten und dem Fremden, im »Dazwischen« liegt laut Hans-Georg Gadamer der eigentliche Ort der Hermeneutik.13 Genau in diesem Zwischenfeld von analoger und digitaler Geschichts- und Archivwissenschaft ist meines Erachtens auch der Ort der digitalen Hermeneutik.14

1. Ontologische Wandlungen:

Von »Quelle« zu »Dokument« zu »Daten«

Die Durchsetzung akademischer Geschichtsschreibung gegen Ende des 19. Jahrhunderts beruhte im Wesentlichen auf drei Glaubenssätzen: erstens dem Ideal der Objektivität, zweitens der Originalität dokumentarischer Quellen und drittens dem professionellen Habitus von akademisch ausgebildeten Historikern (anfangs praktisch ausschließlich Männern).15 Noch heute bilden diese drei Elemente das Fundament des epistemologischen Selbstverständnisses geschichtswissenschaftlicher Forschung – die problematische Metapher der »Quelle« hat nichts von jenem Pathos verloren, das seit den Zeiten des europäischen Humanismus im Aufruf »ad fontes« mitschwingt.16 Die wahrheits- und wirklichkeitsverbürgende Funktion der »Quelle« ist bis heute weitgehend unangetastet, obwohl wissenschaftstheoretischer Konsens darüber besteht, dass eine »Quelle« immer nur in einem abbildhaften oder repräsentativen Wirkungszusammenhang zur historischen Realität stehen kann, nie aber in einem ursächlichen.17 »Quellen« haben also immer doppelten Verweischarakter: einmal auf das in ihnen zum Ausdruck Kommende, zum anderen auf den Entstehungs- und Produktionskontext. Die Kunst der Auslegung der »Quelle« entwickelte sich ausgehend von textexegetischen Interpretationstechniken der Theologie Schritt für Schritt zur Kernkompetenz geschichtswissenschaftlichen Arbeitens und damit zum Dreh- und Angelpunkt der historischen Hermeneutik, wie sie etwa von Johann Gustav Droysen in seinen Vorlesungen zur Historik Mitte des 19. Jahrhunderts dargelegt wurde.18

Quellenkritik als historische Methode schlechthin etablierte sich spätestens mit Werken wie Ernst Bernheims »Lehrbuch der historischen Methode« (1889) oder Charles-Victor Langlois’ und Charles Seignobos’ »Introduction aux études historiques« (1897) – auch wenn beide durchaus unterschiedliche wissenschaftsphilosophische Positionen vertraten.19 Parallel zur Professionalisierung und methodologischen Standardisierung der Geschichtswissenschaft entstand auch die moderne Archivwissenschaft, die sich – im Bestreben einer Abgrenzung von Bibliotheken und Museen sowie einer Emanzipation von der aufstrebenden Geschichtswissenschaft – mit der Entwicklung des Provenienzprinzips eine eigene Methodik gab.20 Die Idee des Archivs als gewachsene Einheit, in der einzelne »Dokumente« oder »Records« wie ein lebendiger und gegliederter Organismus verstanden werden sollten, wurde 1898 erstmals von den niederländischen Archivaren Samuel Muller, Johan Feith und Robert Fruin in einem Handbuch publiziert, welches nach der Übersetzung ins Deutsche, Französische und Englische den archivwissenschaftlichen Diskurs Westeuropas über Jahrzehnte prägte.21

Auch wenn sich Geschichts- und Archivwissenschaft im 20. Jahrhundert zunehmend getrennt und arbeitsteilig entwickelten, werden zentrale Konzepte und professionelle Standards in beiden Disziplinen heute gleichermaßen grundlegend durch die Entwicklung digitaler Infrastrukturen und Techniken herausgefordert. Digitale Quellenkritik – hier verstanden im Sinne einer geschichtswissenschaftlichen Datenkritik – als Teil der digitalen Hermeneutik muss sich deshalb sowohl mit den archiv- als auch den geschichtswissenschaftlichen Fragen beschäftigen, welche sich durch veränderte Logiken der Speicherung, neue Heuristiken des Suchens sowie Methoden der Analyse und Interpretation von Digitalisaten aufdrängen. Betrachtet man Digitalisate als die zentralen »epistemischen Objekte« archiv- wie geschichtswissenschaftlicher Forschung im digitalen Zeitalter, dann gilt es die Konsequenzen der ontologischen und begrifflichen Wandlung von »Quellen« zu »Dokumenten« zu »Daten« auf ihre erkenntnistheoretischen Implikationen zu hinterfragen. Der problematische Begriff der »Quelle« wurde schon erwähnt. Auch der Begriff des »Dokuments« (im Englischen »Record«) ist keineswegs neutral, sondern vielmehr Ausdruck jener Selektions-, Bewertungs-, Indexierungs- und Ordnungslogiken, welche archivalischen Arbeitsprozessen zugrunde liegen. »Documents as evidence are ontological entities whose evidentiary origins lie in their belonging to taxonomic or indexical regimes or to looser discursive or conversational regimes«, so der Professor für Informations- und Bibliothekswissenschaften Donald E. Day.22 Werden im Zuge von Retrodigitalisierungsmaßnahmen aus Archivdokumenten Digitalisate, so findet ein erneuter ontologischer Wandel statt, der das Konzept des »Originals« aus epistemologischer Sichtweise problematisch macht. Aber auch »digital born«-Daten sind keineswegs statisch, sondern zeichnen sich durch ihre relationale und dynamische Natur aus.

2. Geschichtswissenschaftliche Datenkritik:

Integrität, Authentizität und Historizität von Daten

Der Glaube, dass uns eine historische »Quelle« einen privilegierten oder »authentischen« Zugang zur Vergangenheit eröffne, ist genauso naiv wie der Glaube an die Neutralität von Daten. »Raw data is an oxymoron«, so hat es der amerikanische Wissenschaftshistoriker Geoffrey Bowker schon 2005 auf den Punkt gebracht.23 »Data are always already ›cooked‹ and never entirely ›raw‹«, so schlussfolgern auch die Medien- und Literaturwissenschaftlerinnen Lisa Gitelman und Virginia Jackson in der Einleitung zu einem maßgeblichen Sammelband, der Bowkers Perspektive aufgreift.24 Daten – seien sie »big« oder »small«, strukturiert, semi-strukturiert oder unstrukturiert, quantitativ oder qualitativ, primär, sekundär oder tertiär – sind immer schon das Resultat eines Prozesses, dem bestimmte Erkenntnisinteressen, kategoriale Entscheidungen und methodologische Prämissen zugrunde liegen.25 Die Wissenschafts- und Technikhistoriker Bruno Strasser und Paul Edwards argumentieren in ihrem Aufsatz »Big Data Is the Answer... But What Is the Question?« überzeugend, dass etwas als »Daten« zu bezeichnen gleichbedeutend mit einem zeitgebundenen normativen Akt der Bedeutungszuschreibung ist: »To attach the label ›data‹ to something is to place that thing specifically in the long chain of transformations that moves from nature to knowledge; this act of categorization marks a particular moment in time when someone thought some inscription or object could serve to ground a knowledge claim.«26

Geschichtswissenschaftliche Datenkritik muss also nicht nur danach fragen, ob digitale Metaquellen integer sind, sondern immer auch die Historizität der elektronischen Datenträger und Formate reflektieren. Historische »Quellen« oder »Dokumente« in digitaler Form müssen genau wie ihre »analogen« Verwandten auf ihre Provenienz untersucht werden; überhaupt behalten die traditionellen Fragen der historischen Quellenkritik auch für digitale Objekte selbstverständlich ihre Gültigkeit. Die »geschichtete« oder »verteilte Materialität« digitaler Objekte,27 d.h. ihre intrinsische Verwobenheit mit Hard- und Software-Umgebungen, die ihre Speicherung, Darstellung, Analyse und Wiederverwendbarkeit erst möglich machen, erfordern aber eine informationstechnische Erweiterung des Handwerkszeugs und der Kompetenzen der Geschichtswissenschaft. Auch wenn das Konzept des »Originals« bei Digitalisaten aufgrund der dynamischen Konsistenz digitaler Objekte nicht mehr sinnvoll ist, stellt sich auch bei ihnen die Frage nach ihrer Authentizität – und besonders nach ihrer Integrität.

Wie Pascal Föhr in seiner Dissertation zur digitalen Quellenkritik systematisch ausgeführt hat, ist es geboten, zwischen historischer und informationstechnischer Authentizität zu unterscheiden. Während der historische Authentizitätsbegriff die prozesshafte Überprüfung der »Wahrheit«, »Echtheit« oder »Faktizität« von Überlieferungen aus der Vergangenheit meint (Authentizität wird also erst durch den Akt der Authentifizierung erzeugt),28 erfolgt die Bestimmung des Authentischen in der Informationswissenschaft durch die Überprüfung der Integrität von Daten.29 Die informationstechnische Integrität digitaler Daten umfasst die Unversehrtheit des Bitcodes sowie die »semantische Korrektheit«, das heißt, dass der reale und der modellierte Sachverhalt identisch sein müssen. Beschädigungen des Bitcodes auf dem Transportweg (z.B. während eines Speicher- oder Kopierprozesses) führen unweigerlich zu einem Informationsverlust und verletzen so die Integrität des »Dokuments«.30 Laut Matthew Kirschenbaum, Professor für digitale Wissenschaft an der Universität von Maryland, bedeutet jeder Speicherprozess aus forensischer Perspektive eine digitale Manipulation: »One can, in a very literal sense, never access the ›same‹ electronic file twice, since each and every access constitutes a distinct instance of the file that will be addressed and stored in a unique location in computer memory. […] Access is thus duplication, duplication is preservation, and preservation is creation – and recreation. That is the catechism of the .txtual condition, condensed and consolidated in operational terms by the click of a mouse button or the touch of a key.«31

Bei der Speicherung oder der Migration großer Datensätze ist die Überprüfung der informationstechnischen Integrität technisch komplex und erfordert den Einsatz spezialisierter Software. Gerade diese Wissens- und Kompetenzverlagerung von der historisch-kritischen Methode zu computer- und informationswissenschaftlichen Verfahren bei der Bestimmung von Datenintegrität führt zu Bruchbildungen in den »Kontrollzonen« archiv- oder geschichtswissenschaftlicher Institutionen und Disziplinen.32 So wie die Herausbildung der historischen Hermeneutik als Spiegel der Verwissenschaftlichung des Faches Geschichte im 19. Jahrhundert gelesen werden kann, muss die aktuelle Debatte um »Beglaubigungs- und Verbürgungskategorien«33 authentischer Speicherung, Wiedergabe und Nutzung von digitalen historischen Informationen als Professionalisierungsdiskurs gedeutet werden, in dem Archive und Geschichtsforschung grundlegende Kriterien und Konzepte wissenschaftlicher Praxis neu ausloten und verhandeln. Die authentifizierende Autorität archivalischer Institutionen steht dabei genauso zur Debatte wie die kritische Kompetenz der Geschichtswissenschaft beim Umgang mit Digitalisaten.34

Neben der informationstechnischen Integrität von Daten gilt es auch die inhaltliche Integrität zu überprüfen, das heißt, ob der Aussagegehalt von kopierten oder migrierten Datensätzen identisch ist. Kleinere Manipulationen auf der informationstechnischen Ebene müssen nicht notgedrungen zu Veränderungen des dargestellten Inhalts (der »Aussage«) führen. Es bietet sich vor allem bei der Reproduktion digitaler historischer »Quellen« oder »Dokumente« an, hier statt von inhaltlicher besser von Darstellungsintegrität zu reden. Dazu zählt auch das Problem, dass alle digitalen Nutzungsumgebungen einen Einfluss auf die Darstellung bzw. digitale Rekonstruktion von Daten haben. Was als »digitale Quelle« auf dem Computerbildschirm oder dem Smartphone abgebildet wird, ist immer das Resultat einer digitalen Recodierung und Rekontextualisierung, die der Soft- wie Hardware der Nutzertechnologien eingeschrieben sind. »When working with digital objects it’s essential to remember that what they look like on the screen is a performance«, so der Leiter der Abteilung »Digital Content Management« der Library of Congress in Washington D.C., Trevor Owens.35 Interface-Kritik ist darum ein zentraler Bestandteil der digitalen Hermeneutik; dies gilt besonders für die Arbeit mit Webarchiven.

Abgesehen von dem vor allem für zukünftige zeithistorische Forschungen essentiellen Problem, dass das Leitmedium des 21. Jahrhunderts bisher nur extrem lückenhaft archiviert wird, haben wir es bei Webarchiven mit einem speziellen digitalen Konglomerat zu tun, welches Niels Brügger als »reborn digital medium« beschreibt.36 Das World Wide Web ist ein Medium, das sich durch eine komplexe Struktur auszeichnet (sichtbare und unsichtbare Textebenen, Hyperlinks und fragmentierte Informationseinheiten). Diese dynamische und relationale Architektur des WWW ist dafür verantwortlich, dass wir es beim Wiederaufrufen archivierter Webpages mit digitalen Wiedergeburten zu tun haben, deren informationstechnische, inhaltliche wie darstellerische Integrität auf multiple Weise korrumpiert sind. Eine archivierte und »wiedergeborene« Webpage ist immer das Resultat einer doppelten Transformation: Sowohl die Archivierung (etwa durch die Benutzung von »Webcrawling Software«37) als auch die Wiederaktivierung (zum Beispiel durch die »Wayback Machine«38) greifen aktiv in die semantische Ordnung und visuelle Repräsentation der relationalen Datenbestände ein und machen so klassische Prinzipien der Archivwissenschaft wie »respect des fonds« und »respect de l’ordre« obsolet.39

3. Müssen zukünftige Historiker zu digitalen Forensikern ausgebildet werden?

Trotz Massendigitalisierung, omnipräsenten digitalen Forschungsinfrastrukturen und Online-Fachkommunikation unterscheiden sich die epistemologischen Kulturen der Computer- und der Geschichtswissenschaft früher wie heute fundamental; daran dürfte sich auch in Zukunft wenig ändern.40 Dennoch erfordert die hybride Praxis archiv- und geschichtswissenschaftlicher Arbeit ein Umdenken in der Ausbildung zukünftiger Historiker und Archivare. Die heutige Lehre muss ein Bewusstsein für die epistemologischen und methodologischen Implikationen schaffen, welche die Herstellung und Nutzung (d.h. implizit auch Ko-Konstruktion und Manipulation) digitaler Daten für die historische Forschung bedeuten. Das Arbeiten mit digitalen Objekten erfordert ein Grundverständnis der dynamischen, relationalen und fragilen

Natur von Daten als »epistemischen Objekten« der historischen Forschung.41 Historiker müssen lernen, algorithmisch zu denken: »to think about how code might operate, how digital objects are created and stored, and to realize the human dimensions behind programming languages. Decisions are never neutral, and historians will need to be equipped to evaluate the tools and platforms they use.«42

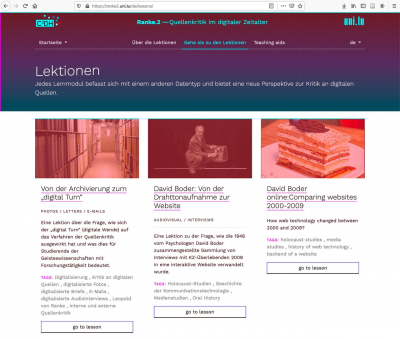

Genau dies ist das Ziel der Lernplattform für digitale Quellenkritik »Ranke.2«, die am Luxembourg Centre for Contemporary and Digital History entwickelt wurde und kontinuierlich ausgebaut wird.43 Die Plattform bietet Studierenden wie professionellen Historikern die Möglichkeit, sich in unterschiedlichen thematischen Modulen mit zentralen Fragen der geschichtswissenschaftlichen Datenkritik bzw. digitalen Quellenkritik auseinanderzusetzen. Neben dem Ziel, Studierende und Lehrende für die wichtige Thematik zu sensibilisieren – was in allen Lektionen durch kurze, animierte Videos und Quizformate geschieht –, sind problemorientierte Module für den Unterrichtskontext im BA- und MA-Niveau ausgelegt. Sie bieten Lehrmaterialien, Übungen und Onlineverweise, welche die unterschiedlichen Dimensionen der digitalen Quellenkritik am Beispiel unterschiedlicher Quellengattungen oder Datensätze systematisch problematisieren. Zurzeit bietet die Lernplattform fünf thematische Module an; weitere sind in Arbeit. Diese sollen künftig vor allem in Zusammenarbeit mit Partnern realisiert werden, die ihre spezifische Expertise (z.B. einer bestimmten Quellengattung) einbringen können.44

Sich als Historiker mit den Chancen und Herausforderungen der geschichtswissenschaftlichen Datenkritik zu beschäftigen ist nicht länger eine Option, sondern eine Notwendigkeit. Historiker müssen nicht zu digitalen Forensikern (im Sinne von technischen Datenspezialisten) mutieren.45 Aber ohne ein systematisches Trainieren alter und neuer Kernkompetenzen im Sinne einer digitalen Hermeneutik lassen sich Fragen von Evidenz und Transparenz der Wissenschaft auch in der Historiographie nicht glaubhaft diskutieren; es geht somit um die Legitimität des Faches als kritische Wissenschaft.

Anmerkungen:

1 Achim Landwehr, Die anwesende Abwesenheit der Vergangenheit. Essay zur Geschichtstheorie, Frankfurt a.M. 2016, S. 180.

2 Siehe stellvertretend Viktor Mayer-Schönberger/Kenneth Cukier, Big Data. A Revolution That Will Change How We Live, Work and Think, Boston 2013; dt.: dies., Big Data. Die Revolution, die unser Leben verändern wird. Übersetzung aus dem Englischen von Dagmar Mallett, München 2013.

3 Siehe etwa Evgeny Morozov, To Save Everything, Click Here. The Folly of Technological Solutionism, New York 2013; dt.: ders., Smarte neue Welt. Digitale Technik und die Freiheit des Menschen. Aus dem Englischen von Henning Dedekind und Ursel Schäfer, München 2013; Shoshana Zuboff, Das Zeitalter des Überwachungskapitalismus. Aus dem Englischen von Bernhard Schmid, Frankfurt a.M. 2018.

4 Rob Kitchin, The Data Revolution. Big Data, Open Data, Data Infrastructures and Their Consequences, London 2014.

5 Andreas Fickers, »Neither good, nor bad, nor neutral«. The Historical Dispositif of Communication Technologies, in: Martin Schreiber/Clemens Zimmermann (Hg.), Journalism and Technological Change. Historical Perspectives, Contemporary Trends, Frankfurt a.M. 2014, S. 30-52.

6 Toni Weller (Hg.), History in the Digital Age, London 2013.

7 Daniel Cohen/Roy Rosenzweig, Digital History. A Guide to Gathering, Preserving, and Presenting the Past on the Web, Philadelphia 2006.

8 Ian Milligan, History in the Age of Abundance? How the Web Is Transforming Historical Research, Montreal 2019, S. 14.

9 Siehe hierzu auch Andreas Fickers, Digitale Metaquellen und doppelte Reflexivität, in: H-Soz-Kult, 26.1.2016.

10 Zum Konzept der digitalen Hermeneutik siehe die Website des Doktorandenkollegs »Digital Hermeneutics and History« an der Universität Luxemburg sowie Andreas Fickers, Hermeneutics of In-Betweenness: Digital Public History as Hybrid Practice, in: Serge Noiret/Mark Tebeau (Hg.), Handbook Digital Public History, Berlin 2021 (in Vorbereitung); Andreas Fickers/Tim van der Heijden, Inside the Trading Zone: Thinkering in a Digital History Lab, in: Digital Humanities Quarterly 14 (2020) (im Erscheinen).

11 Gerben Zaagsma, On Digital History, in: Low Countries Historical Review 128 (2013) H. 4, S. 3-29, hier S. 15.

12 Max Kemman, The Trading Zones of Digital History, phil. Diss. Universität Luxemburg 2019.

13 Hans-Georg Gadamer, Wahrheit und Methode. Grundzüge einer philosophischen Hermeneutik [1960], Tübingen 2010, S. 300.

14 Zur digitalen Hermeneutik als »Hermeneutics of In-Betweenness« oder »Hermeneutics of Screwing Around« siehe Stephen Ramsey, Reading Machines. Toward an Algorithmic Criticism, Urbana 2011; ders., Hermeneutics of Screwing Around; or What You Do with a Million Books, in: Kevin Kee (Hg.), Pastplay. Teaching and Learning History with Technology, Ann Arbor 2010, S. 111-120.

15 Andreas Fickers, Entre vérité et dire du vrai. Ein geschichtstheoretischer Grenzgang, in: ders. u.a. (Hg.), Jeux Sans Frontières. Grenzgänge der Geschichtswissenschaft, Bielefeld 2018, S. 29-40.

16 Uwe Barrelmeyer, Geschichtliche Wirklichkeit als Problem. Untersuchungen zu geschichtstheoretischen Begründungen historischen Wissens bei Johann Gustav Droysen, Georg Simmel und Max Weber, Münster 1997.

17 Sabine Büttner, Tutorium Arbeiten mit Quellen, in: historicum-estudies.net.

18 Johann Gustav Droysen, Historik. Historisch-kritische Ausgabe von Peter Leyh, Stuttgart 1977.

19 Siehe Rolf Torstendahl, The Rise and Propagation of Historical Professionalism, London 2015; Arthur Alfaix Assis, Schemes of Historical Method in the Late 19th Century: Cross-References between Langlois and Seignobos, Bernheim, and Droysen, in: Luiz Estevam de Oliveira Fernandes/Luísa Rauter Pereira/Sérgio da Mata (Hg.), Contributions and Comparative History of Historiography. German and Brazilian Perspectives, Frankfurt a.M. 2015, S. 105-126.

20 Siehe Christian Keitel, Zwölf Wege ins Archiv. Umrisse einer offenen und praktischen Archivwissenschaft, Stuttgart 2018, S. 17.

21 Samuel Muller/Johan Feith/Robert Fruin, Handleiding voor het oordenen en beschrijven van archieven, Groningen 1898; dt.: dies., Anleitung zum Ordnen und Beschreiben von Archiven. Für deutsche Archivare bearbeitet von Hans Kaiser. Mit einem Vorwort von Wilhelm Wiegand, Leipzig 1905.

22 Donald E. Day, Indexing It All. The Subject in the Age of Documentation, Information, and Data, Cambridge 2014, S. 5.

23 Geoffrey Bowker, Memory Practices in the Sciences, Cambridge 2005, S. 183.

24 Lisa Gitelman/Virginia Jackson, Introduction, in: Lisa Gitelman (Hg.), »Raw Data« is an Oxymoron, Cambridge 2013, S. 2.

25 Zur unterschiedlichen Konzeptionalisierung von Daten siehe Kitchin, Data Revolution (Anm. 4), S. 27-47, und Christine L. Borgman, Big Data, Little Data, No Data. Scholarship in the Networked World, Cambridge 2015.

26 Bruno J. Strasser/Paul N. Edwards, Big Data Is the Answer… But What Is the Question?, in: Osiris 32 (2017), S. 328-345, hier S. 329f.

27 Siehe Jean-François Blanchette, A Material History of Bits, in: Journal of the American Society for Information Science and Technology 62 (2011), S. 1042-1057, sowie Johanna Drucker, Performative Materiality and Theoretical Approaches to Interface, in: Digital Humanities Quarterly 7 (2013).

28 Siehe hierzu die Beiträge in Martin Sabrow/Achim Saupe (Hg.), Historische Authentizität, Göttingen 2016.

29 Pascal Föhr, Historische Quellenkritik im digitalen Zeitalter, phil. Diss. Universität Basel 2018, S. 189 (die Buchausgabe ist unter demselben Titel erschienen, Glückstadt 2019).

30 Siehe Corinne Rogers, Authenticity of Digital Records: A Survey of Professional Practice, in: Canadian Journal of Information and Library Science 39 (2015), S. 97-113.

31 Matthew Kirschenbaum, The .txtual Condition: Digital Humanities, Born-Digital Archives, and the Future Literary, in: Digital Humanities Quarterly 7 (2013), paragraph 16.

32 Carl Lagoze, Big Data, Data Integrity, and the Fracturing of the Control Zone, in: Big Data & Society 1 (2014), S. 1-11, hier S. 6.

33 Susanne Knaller, Ein Wort aus der Fremde. Geschichte und Theorie des Begriffs Authentizität, Heidelberg 2007, S. 22.

34 Eine interessante Plattform zur Diskussion des Verhältnisses zwischen Archiven und Geschichtswissenschaft im digitalen Zeitalter bietet das Projekt »Le goût de l’archive à l’ère numérique« von Caroline Muller und Frédéric Clavert.

35 Trevor Owens, Digital Sources & Digital Archives: The Evidentiary Basis of Digital History, in: David Staley (Hg.), A Companion to Digital History, New York 2020 (in Vorbereitung); Manuskriptfassung unter <https://doi.org/10.31235/osf.io/t5rdy>, dort S. 6.

36 Niels Brügger, The Archived Web. Doing History in the Digital Age, Cambridge 2018, S. 6.

37 Eine praxisorientierte Beschreibung dieser Technik und ihrer Implikationen für die digitale Quellenkritik findet sich bei Milligan, History in the Age of Abundance? (Anm. 8), Kapitel 6: »The (Practical) Historian in the Age of Big Data«, S. 213-235.

38 Bei der »Wayback Machine« handelt es sich um eine Online-Suchmaschine für die Durchforstung des »Internet Archive«, einer privat finanzierten Initiative zur Archivierung des World Wide Web, die 1996 gegründet wurde und derzeit über 400 Milliarden Webpages archiviert. Siehe <https://archive.org/web/>. Vgl. auch Valérie Schafer, De la Wayback Machine à la bibliothèque: les différentes saveurs des archives du Web…, in: La Gazette des archives 253 (2019) H. 1.

39 Jefferson Bailey, Disrespect des Fonds: Rethinking Arrangement and Description in Born-Digital Archives, in: Archive Journal, June 2013. Die dynamische und relationale Struktur digitaler Datenbestände gilt aber nicht nur für Webarchive, sondern – aus forensischer Perspektive – auch für digitale Bestände im Offline-Modus. Siehe hierzu Thorsten Ries, The rationale of the born-digital dossier génétique: Digital forensics and the writing process with examples from the Thomas Kling Archive, in: Digital Scholarship in the Humanities 33 (2018), S. 391-424.

40 Siehe Kemman, Trading Zones of Digital History (Anm. 12).

41 Zum Konzept des »epistemischen Objekts« in der Wissenschaftsgeschichte siehe Hans-Jörg Rheinberger, Historische Epistemologie zur Einführung, Hamburg 2007.

42 Milligan, History in the Age of Abundance? (Anm. 8), S. 241.

43 Siehe <https://ranke2.uni.lu>.

44 Wer Interesse an der Mitentwicklung eines Lehrmoduls hat, möge sich bitte an den Autor wenden.

45 Zum Begriff der »digitalen Forensik« und seiner Bedeutung in der Geschichtswissenschaft siehe Matthew Kirschenbaum/Richard Ovenden/Gabriela Redwine (with research assistance from Rachel Donahue), Digital Forensics and Born-Digital Content in Cultural Heritage Collections. Council on Library and Information Resources, Washington, D.C. 2010.